谷歌日前公布了该公司用于训练人工智能模型 PaLM 的超级计算机的更多细节,谷歌称这个超级计算机比英伟达的同类系统速度更快、功耗更低。

目前 AI 行业主要依靠英伟达的专用加速卡进行训练,典型代表是 OPENAI 使用 20000~30000 张 NVIDIA A100 加速卡,早前英伟达还推出了最新加速卡 NVIDIA H100,性能是 A100 的三倍。

谷歌虽然也使用英伟达的加速卡,不过谷歌自己也在研发芯片,比如谷歌新超级计算机使用的就是谷歌自己研发的第四代张量处理单元 (TPU)。

TPU 主要用于谷歌的人工智能训练,谷歌称公司 90% 的人工智能和机器学习训练都是基于 TPU 单元的,即通过模型提供数据的过程,让这些处理单元在用于类似人类的文本响应查询和图像生成领域发挥作用。

谷歌最新的张量处理单元是第四代即 TPU4,谷歌自 2020 年开始将 TPU4 部署在数据中心组成超级计算机供内部使用。

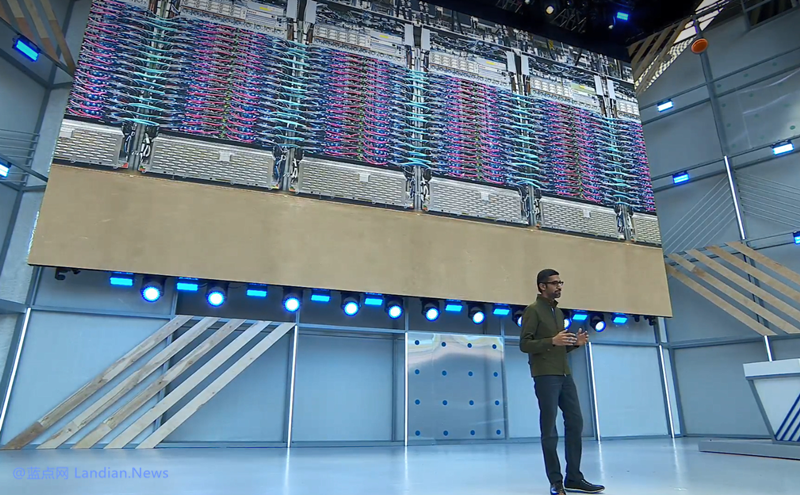

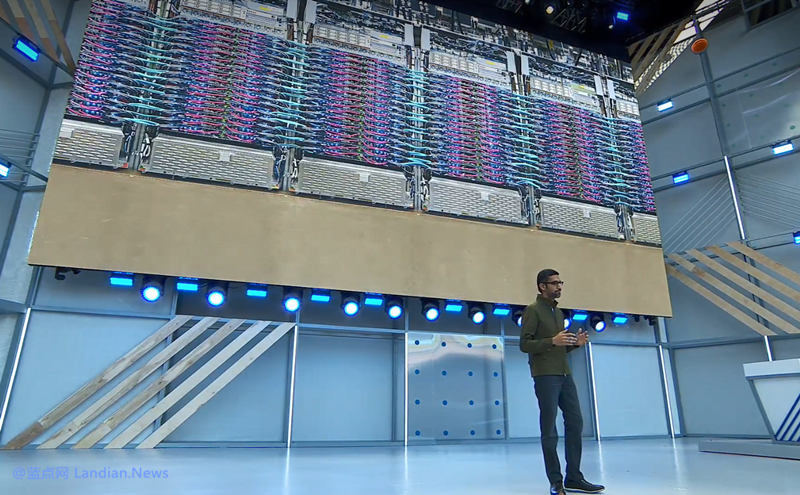

谷歌本周发布了一篇新论文介绍 TPU4 及 TPU4 组成的超级计算机,谷歌工程师利用自己定制开发的光开关将 4000 多个 TPU4 连接在一起组成超算。

难点在于如何让这些处理单元组合起来提供高速运算,因为诸如 ChatGPT、Bard 这类模型数据量太大,靠单个芯片无法支撑。

相反,这些模型必须利用数量夸张的计算单元,然后将数据分布存储在上面,同时还要求每个计算单元能够协同工作数周甚至更长的时间,因此这是一个技术难点。

所以最终谷歌选择自己定制开发专用的光开关,这样 TPU4 超算可以轻松动态配置处理单元之间的连接,降低延迟、提高性能满足计算需求。

性能对比方面,谷歌在论文中表示对于同等大小的系统,TPU4 超算比 NVIDIA A100 超算快 1.7 倍、能效提高 1.9 倍,A100 上市时间与 TPU4 完成开发类似,所以可以对比,而最新发布的 H100 属于更先进的产品了,谷歌没对比。

那么标题中为什么要说谷歌 “吹嘘” 呢?我们倒不是怀疑谷歌的研发能力,主要是谷歌自研的这些芯片 (包括用于手机上的 AI 芯片) 都不对外出售的,也就是只有谷歌自己能使用。

所以即便性能提升多少对其他 AI 企业来说好像也没太大意义,不过谷歌也倒不是完全封锁,谷歌通过 Google Cloud 云计算服务对外出租 Cloud TPU 算力,所以 AI 企业要想使用 TPU 还必须使用 Google Cloud,妥妥的捆绑销售了,要知道云计算成本可比自己购买芯片后长期使用的成本高的多,所以对大型 AI 企业来说这并不划算。

另外谷歌暗示该公司还在开发新一代 TPU,毕竟 TPU4 都是 2020 年之前的事儿了,谷歌要研发第五代张量计算单元与 NVIDIA H100 竞争。

版权声明:感谢您的阅读,除非文中已注明来源网站名称或链接,否则均为蓝点网原创内容。转载时请务必注明:来源于蓝点网、标注作者及本文完整链接,谢谢理解。