“GPT-5将在6月发布”的消息刷屏了AI朋友圈。当用户还沉浸在GPT-4的强大功能之中,没想到GPT-5这么快就又要发布了,AI的迭代速度如此之快,远远超越了摩尔定律的限制。

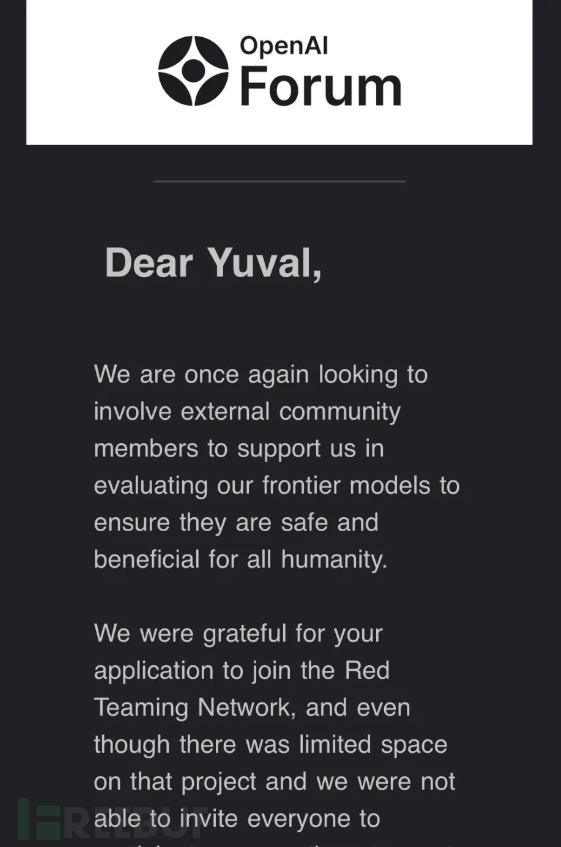

而这则消息之所以被无数人相信并转发,是因为已经有不少技术人员在社交平台上晒出了“红队测试邀请”。因此不少人猜测 GPT-5 的发布日期可能比预期(2024年6月)更早,甚至有人呼吁 OpenAI CEO Sam Altman 加快发布进程。

作为生成式人工智能的领头羊,OpenAI 一直走在行业的前列,自ChatGPT发布并爆火以来,拥有着其他平台难以比拟的庞大的用户体量。和已经收获大量流量和用户的GPT-4相比,GPT-5的功能将更加强大,采用更先进的架构,使用更广泛和多样化的训练数据集,以更像人类的方式理解和生成语言...

作为生成式人工智能的领头羊,OpenAI 一直走在行业的前列,自ChatGPT发布并爆火以来,拥有着其他平台难以比拟的庞大的用户体量。和已经收获大量流量和用户的GPT-4相比,GPT-5的功能将更加强大,采用更先进的架构,使用更广泛和多样化的训练数据集,以更像人类的方式理解和生成语言...

基于此,OpenAI 将更加重视GPT-5 的安全性,考虑到 GPT-5 可能带来的潜在影响和商务付费方面的深度拓展,发布之前必须要进行严格的红队测试。

红队测试是不可或缺的安全措施

所谓红队测试,是指网络安全技术专门们共同模拟攻击者,在真实的环境下对目标系统进行网络攻击,以便提前发现潜在的系统漏洞,确保系统的安全性。

由于AI工具的能力十分强大,因此在AI开发领域红队测试的重要性更加明显,是不可或缺的安全措施之一。在使用 LLM 时,无论是良性使用还是对抗性使用都可能产生潜在的有害输出,这些输出可能表现为多种形式,包括有害内容,如仇恨言论、煽动或美化暴力或性内容。

2023年9月,OpenAI曾面向全球招募AI红队测试人员,不断挖掘AI潜在的风险和如何滥用工具作恶等。与过往仅在重要版本上线前招一批人集中测试不同,OpenAI将会根据需求在整个开发周期中启用数量不定的成员展开测试,其类型主要包括提示攻击、数据中毒、后门攻击、对抗性示例、数据提取等。

「提示攻击」是指在控制LLM的提示中注入恶意指令,从而导致大模型执行非预期的操作。今年早些时候,一名大学生利用提示获取了一家大公司的机密信息,包括开发的AI项目的代码名称,以及一些本不应该暴露的元数据。而「提示攻击」最大的挑战是,找到威胁行为者尚未发现、利用的新提示或提示集。

美国罗彻斯特大学的化学工程教授Andrew White介绍称他曾参加GPT-4的“红队”测试,他的攻击目标是用ChatGPT来创造一种全新的神经毒素。White表示他用了“插件”功能,向大模型输送化学论文和化学制造商的目录,大模型甚至还给他找到了一个可以生产假想毒素的地方。

“我认为它将为每个人配备一个工具,以更快、更准确地进行化学研究”,White表示,“但也有很大的风险,人们可以进行危险的化学实验。现在,这种情况确实存在。”

这一发现也让OpenAI进一步加强了在红队测试方面的重视与投入。事实上,AI开发者们围绕语言模型的快速进展有着共同的担忧,特别是通过插件将其与外部知识来源连接的风险。红队测试恰好是以最低的成本来解决人工智能系统广泛存在的危险。

例如OpenAI 希望寻找模型中有害、偏见和语言偏差等问题,因此红队测试了谎言、言语操纵和危险的科学知识,他们还检查了其协助和教唆剽窃、金融犯罪和网络攻击等非法活动的潜力,以及它如何可能损害国家安全和战场通信等等。

此外,技术和人权研究人员 Roya Pakzad 使用英语和波斯语提示来测试该模型的性别化反应、种族偏好和宗教偏见,特别是关于头饰的问题。

Pakzad 承认这种工具对非英语母语者的好处,但他发现,即使在后来的版本中,该模型也显示了对边缘化社区的明显刻板印象。她还发现,当聊天机器人用捏造的信息做出反应时,在用波斯语测试该模型时更糟糕,Pakzad 发现与英语相比,波斯语中捏造的名字、数字和事件的比例更高。

就目前来说,AI红队测试可以归纳为以下:

1、AI红队更具扩张性:应对的安全问题更多更复杂,还需要探索公平性问题、有害内容等。

2、AI红队需要同时关注恶意和善意的使用者:除恶意对手会利用漏洞破坏AI系统,普通用户在交互过程中也会产生问题和有害内容。

3、AI系统在不断发展:AI系统的变化速度比传统应用更快,需要进行多轮红队测试,建立系统化、自动化的测量和监测系统。

4、AI系统红队测试需要多次尝试:生成式人工智能系统的结果是概率性的,因此可能需要多次尝试,才能发现问题。

5、减少AI问题需要深度防御:修复通过AI红队发现的故障需要深度防御方法,包括使用分类器标记潜在的有害内容,使用元提示符指导行为以限制会话漂移等。

不仅仅是openAI,微软同样加强红队测试

作为openAI的股东以及另外一家研发AIGC工具的巨头,微软在红队测试上同样投入了大量的人力和资源。一直以来,微软都在持续规划大型语言模型 (LLM) 及其应用程序的红队测试,旨在保护旗下AI工具的安全性。

例如对AI工具进行开放式测试,以发现各种危害。RAI 红队成员探索和记录任何有问题的内容(而不是要求他们查找特定危害的示例)的好处,是使他们能够创造性地探索各种问题,以发现对风险表面理解的盲点。

微软人工智能红队创始人库马尔表示,AI红队在工作方式上与传统红队却有显著差异。“我们在大型语言模型上看到了一些新颖的攻击——只需要一个满嘴脏话的青少年,或是一个使用浏览器的休闲用户,我们不想忽视它。如果你只把人工智能红队看作传统的红队,那可能还不够,不仅要考虑安全问题,还要考虑负责任的人工智能问题。”

当然,库马尔也表示,提出这种区别需要时间,AI红队的许多早期工作仍然与发布传统的安全工具有关。

2020年10月,微软与MITRE等合作伙伴共同开发并发布了对抗性机器学习威胁矩阵(Adversarial Machine Learning Threat Matrix),供安全分析师检测、响应和修复AI威胁。同年,微软研发并开源了Counterfit——一项用于人工智能系统安全测试的自动化工具。

2024年,微软发布了PyRIT(用于生成式人工智能的Python风险识别工具包)红队测试工具,通过自动化帮助识别生成式人工智能中的风险。这是一个开源的红队测试工具,旨在帮助安全专业人员和机器学习工程师识别生成式人工智能中的风险。PyRIT通过自动化任务和标记需要进一步调查的领域,提高了审计效率,本质上增强了手动红队测试。

微软指出,对生成式人工智能进行红队测试与探测传统的人工智能系统或传统系统不同,主要是因为它需要识别安全风险和人工智能风险,生成式人工智能更具概率性,且由于生成式人工智能系统架构的广泛变化。

“PyRIT不是手动红队测试生成式人工智能系统的替代品,相反它增强了人工智能红队测试人员现有的领域专业知识,并为他们自动化了繁琐的任务。PyRIT能够揭示风险可能存在的热点区域,安全专业人员可以深入探索。”

这个工具允许用户控制人工智能红队操作的策略和执行,可以基于它所接收的集合生成额外的有害提示,并根据从生成式人工智能系统收到的响应改变策略。

PyRIT支持各种生成式人工智能目标公式,可以输入动态提示模板或一组静态的恶意提示,提供了两种评分目标系统输出的选项,支持两种攻击策略风格,并且可以保存中间输入和输出交互以供后续分析。

微软指出:“PyRIT的创建是为了践行我们长期以来的初衷,即在整个行业内共享人工智能红队资源可以提升所有人的水平。我们鼓励在行业内的同行花时间研究这个工具包,看看它如何能够被用于你自己的生成式人工智能应用的红队测试。”

任何时候,AI红队测试都要做

尽管红队测试在AI领域还停留在发现漏洞与风险,而非像网络安全领域红队蓝队之间的攻防对抗。但即便如此,红队测试,任何GPT类型的人工智能工具都需要做;只有通过红队测试的GPT,才是合格的AI,才是能够在市场上推广的AI。

Micah Zenko曾表示,红队测试与人工智能发展速度之间存在明显的不匹配。当下AI工具发展与迭代速度非常快,红队测试如何快速跟上发展的步伐极为关键。

对于人工智能而言,Data & Society的技术专家认为,红队测试不应该在公司内部进行,并提出建议:需要独立的厂商进行验证,同时建立跨职能的红队测试团队,而不仅仅是黑客与开发者。

Center for AI Safety指出,红队测试也不应被视为万能的解决方案。“这项技术一定有用,但它只是防御人工智能潜在风险的一道防线,更广泛的政策和方法生态系统才是必不可少的。”

目前,NIST正在研究、制定红队测试相关办法,目前已经组建了200个联盟来制定更加完善、细分的AI红队测试标准。与此同时,不少大型科技集团也在这方面进行发力,例如Anthropic、Google、微软和OpenAI打造了FMF论坛,为人工智能安全标准制定投入更多资源。

或许,我们也该在AI红队测试上制定一些规则和措施,为以后AI的发展与应用留下足够的空间。

如有侵权请联系:admin#unsafe.sh