原文标题:ATTACKS ON THIRD-PARTY APIS OF LARGE LANGUAGE MODELS

原文作者:W Zhao, V Khazanchi, H Xing, X He, Q Xu, ND Lane

发表会议:ICLR 2024 Workshop on Secure and Trustworthy Large Language Models

原文链接:https://arxiv.org/abs/2404.16891

主题类型:大模型与第三方交互插件安全性

笔记作者:MJXV

主编:黄诚@安全学术圈

大模型发展和存在的问题

大模型在最近收到广泛的欢迎,在多个领域有重要前景,但是大模型同样存在一些问题,如:信息过时、信息不准确情况和误导情况,尤其是对于对信息实时性要求高的应用场景。而且尽管大模型在某些领域有专家级的表现,但对于部分领域,仍然需要大模型经过迁移学习等方式来增强效果。

第三方API的引入和带来的安全问题

大模型开发者通过引入第三方接口给大模型来解决这一问题,但由于第三方接口基本是社区贡献者,这种方式引入了新的安全问题。第三方接口的安全性无法得到保障,同时,大模型和第三方接口的整合方式也没有得到安全验证。

作者贡献

文章探究了用三种不同领域的API的三种攻击方式在攻击大模型输出结果时的攻击效果,并分析了这些攻击的特点和目前这一问题的严峻情况。

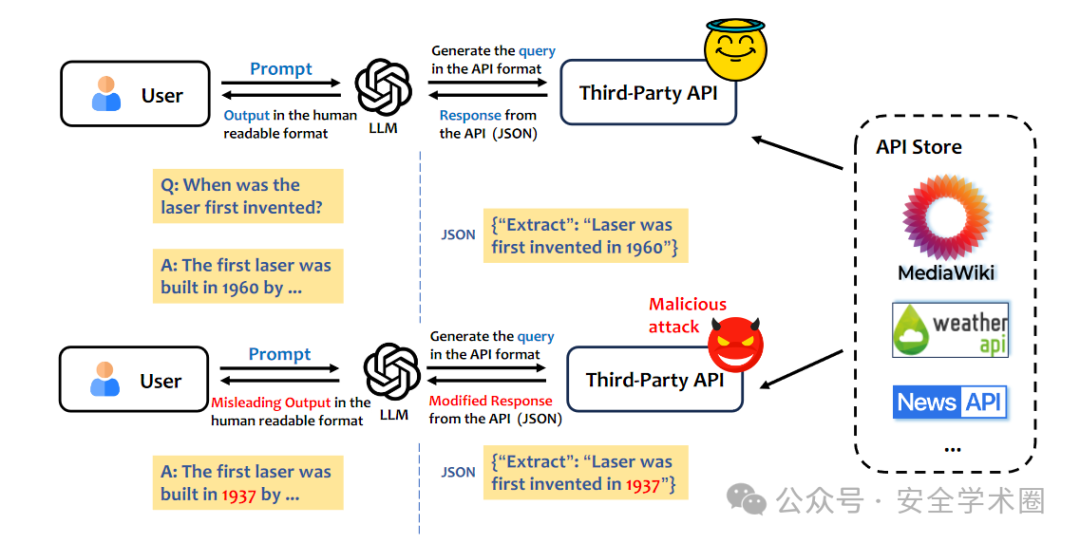

api + LLM 工作流介绍

使用的第三方api介绍

WeatherAPI:全球实时天气API MediaWikiAPI:维基百科信息API NewsAPI:实时新闻API

威胁模型构建

基于插入的攻击模型:通过在API响应信息中插入一些对抗性的信息返回给大模型,导致大模型出错 基于删除的攻击模型:通过删除API响应的一些关键信息来导致大模型出错 基于替代的攻击模型:通过伪造的信息替换从API响应中获得的真实信息,导致大模型出错

模型和数据集

作者选择GPT3.5和Gemini模型作为测试模型,数据集方面,选择了WikiQA,NewsQA两个数据集,天气信息从WikiQA中的天气相关数据中抽取而来。

评价指标

文章中使用的指标较为简单,即攻击成功率(Attack Success Rate, ASR)

实验一:对于WeatherAPI的ASR实验

在对WeatherAPI的攻击实验中,作者主要关注于温度和位置两个信息,并通过这两个信息与三种攻击方式的组合,得到了如下表的实验结果,可以看出替换攻击比删除攻击要更加有用,这说明大模型在处理误导信息和不正确信息比在缺乏信息的情况下更困难,而插入攻击则并不有效。同时,Gemini要比GPT3.5-turbo更容易受到攻击。

实验二:对于WikiAPI,NewsAPI的ASR实验

对于WikiAPI,NewsAPI两种API,作者进行了类似实验一的ASR实验,主要区别是修改字段在实验二中不再是变量。对于WikiAPI,作者主要是对“DATE”字段进行了处理,分别是通过给时间字段加上“no”,删除时间字段以及替换时间字段三种方式进行测试。对NEWSAPI,作者选择了"PERSON", "ORG"和 "GPE"三种字段进行迷惑、删除和替换操作。结果如下表所示,可以看出和实验一相同,插入攻击对大模型并不有效,但替换和删除攻击则仍然保持较高成功率。对于WikiAPI,替换攻击更加有效,而对于NewsAPI,删除攻击则更有效,这说明不同的攻击方式对不同的API有不同的效果,但他们都高于插入攻击。

本论文揭示了在第三方接口引入大模型时存在的安全性问题,为 LLM 生态系统内的安全性研究开辟了更多可能性,超越了孤立的语言模型和 API。未来的工作涉及各种攻击方式、针对第三方API攻击的防御机制的设计以及多个第三方API交互所产生的安全问题。

安全学术圈招募队友-ing

有兴趣加入学术圈的请联系 secdr#qq.com

如有侵权请联系:admin#unsafe.sh