#技术教程 谷歌在 Chrome 浏览器中内置了 AI 模型,完全在本地运行,不过需要下载 1.7GB 的模型数据到本地。启用后现阶段可以在 F12 控制台中以命令行形式与 Gemini Nano 对话,响应速度还是挺快的。查看全文:https://ourl.co/104387

此前谷歌在推出 Gemini 新版本时曾发布适用于智能手机和其他配置较低的设备的 Gemini Nano 版,该模型参数规模较小适合在智能手机等场景中本地运算。

现在谷歌已经将这个模型内置到 Google Chorme 浏览器中,让用户可以利用本地计算机的硬件性能,调用 Gemini Nano 回答问题。

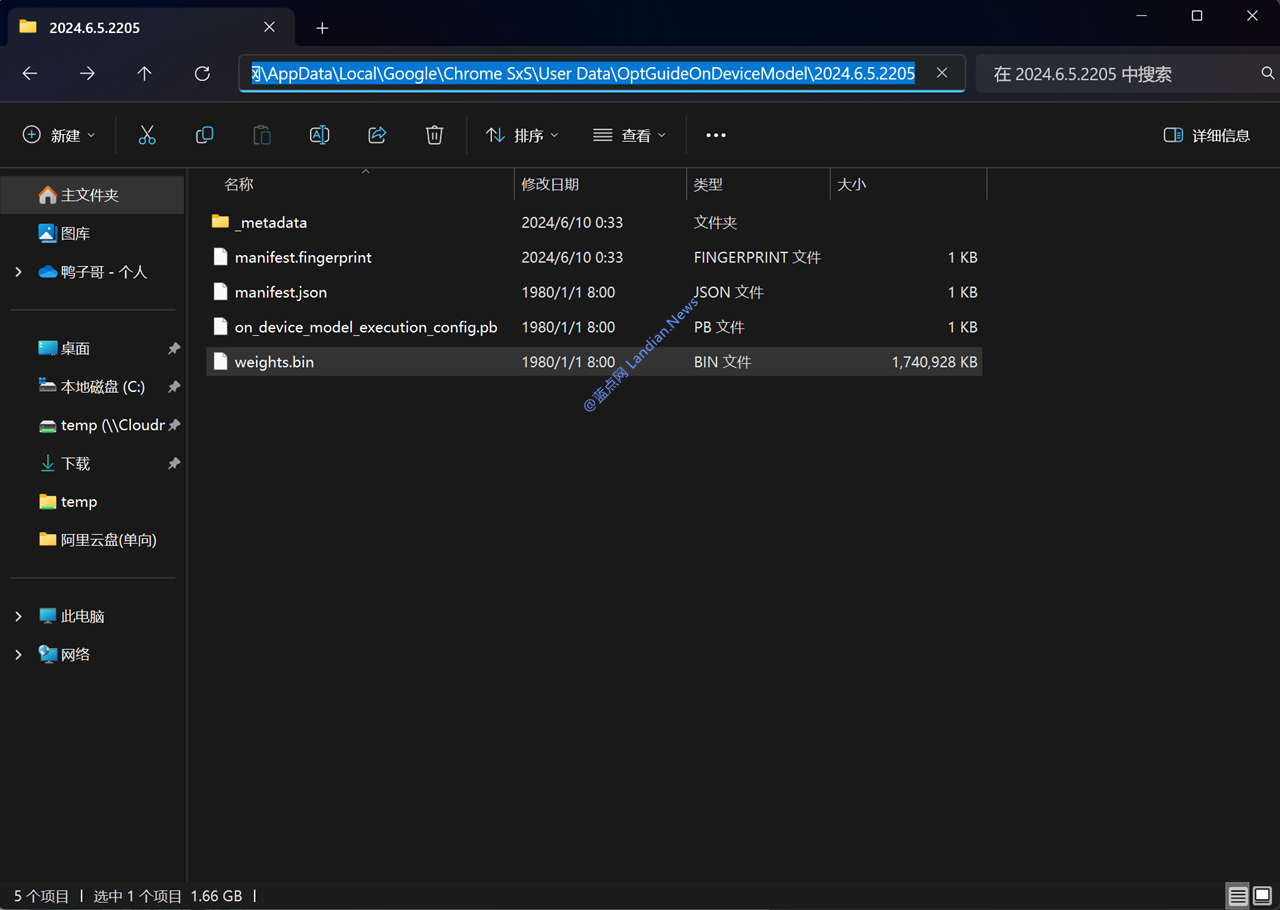

目前此功能仅在 Chrome Canary 版中测试,下载的 Gemini Nano 模型体积约为 1.4GB 左右,解压后的模型大小为 1.74GB,成功启用模型后可以在 F12 控制台中运行。

得益于模型完全是在本地运算的,因此在提问时可以立即响应并快速获得回答,这种场景下效率实际上比使用云端版本的 AI 模型还要快,但因为 Nano 模型参数规模较小所以数据有限,某些问题的推理效果可能不如云端版本。

有兴趣的用户可以安装 Chrome Canary 进行测试,下面是启用方法:

1. 转到此路径并将其选项修改为 Enabled BypassPerfRequirement (不要按提示重启浏览器)

chrome://flags/#optimization-guide-on-device-model

2. 转到此路径并将其选项修改为 Enabled (不要按提示重启浏览器)

chrome://flags/#prompt-api-for-gemini-nano

3. 转到组件页面检查模型下载情况:chrome://components/

其中 Optimization Guide On Device Model 即为模型,目前最新版本为 2024.6.5.2205,如果已经成功下载则这里会显示版本号。如果没有显示模型组件,请禁用第 1、2 步的设置然后重启浏览器再重新启用。

4. 当模型下载完成后按 F12 进入控制台输入 window.model.createTextSession () 如果没有报错那就是启用成功。

版权声明:

感谢您的阅读,本文由 @山外的鸭子哥 转载或编译,如您需要继续转载此内容请务必以超链接(而非纯文本链接)标注原始来源。原始内容来源:X@Leeoxiang

![[技巧] 谷歌在Chrome浏览器中内置AI模型可以本地对话 下面是开启方法](https://img.lancdn.com/landian/2024/06/104387-1.png)

![[技巧] 谷歌在Chrome浏览器中内置AI模型可以本地对话 下面是开启方法](https://img.lancdn.com/landian/2024/06/104387-2.png)

![[技巧] 谷歌在Chrome浏览器中内置AI模型可以本地对话 下面是开启方法](https://img.lancdn.com/landian/2024/06/104387-3.png)

![[技巧] 谷歌在Chrome浏览器中内置AI模型可以本地对话 下面是开启方法](https://img.lancdn.com/landian/2024/06/104387-4.png)

![[技巧] 谷歌在Chrome浏览器中内置AI模型可以本地对话 下面是开启方法](https://img.lancdn.com/landian/2024/06/104387-5.png)