引用

牟奕洋, 陈涵霄, 李洪伟. 大语言模型的安全与隐私保护技术研究进展[J]. 网络空间安全科学学报, 2024, 2(1): 40-49.

MU Yiyang, CHEN Hanxiao, LI Hongwei. Advances in security and privacy−preserving techniques for large language models[J]. Journal of Cybersecurity, 2024, 2(1): 40-49.

背 景

大语言模型作为人工智能领域的一项革命性技术,正引领我们进入一个全新的数字时代。这类强大的机器学习模型不仅拥有极其庞大的参数数量,还具备前所未有的自然语言理解和生成能力,能够进行模仿人类理解和创作这样高度复杂性的行为。大语言模型已经在多个领域展现出广泛的应用潜力,包括自然语言处理、机器翻译、文本生成、智能对话系统等。然而,随着人们对大语言模型的深入开发和研究,其安全和隐私问题也变得尤为重要。应用大语言模型所导致的数据安全与隐私问题频发,并且对隐私信息的过度收集和非法利用严重违反了我国的法律法规,如《中华人民共和国个人信息保护法》。因此,如何保障大语言模型的安全以及如何保护用户的隐私敏感信息成为大语言模型发展和应用的基础。研究人员以针对语言模型安全性问题的研究为起点,尝试将现有的研究成果延伸到大语言模型领域,设置实验发掘大语言模型可能存在的漏洞与潜在的安全威胁,并应用防御措施观察其应对效果,尝试突破大语言模型所面临的安全与隐私困境。

过程研究

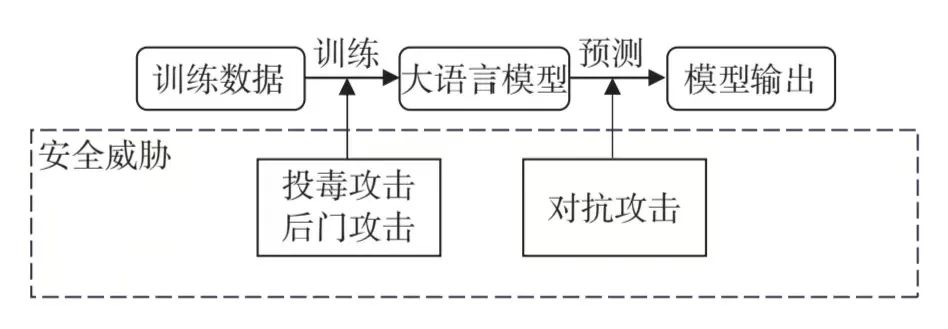

由于优秀的自然语言解析和处理能力,大语言模型在人们生活场景中的应用越来越普遍,其安全性成为至关重要的问题。例如敌手可以对过滤垃圾邮件的大语言模型进行攻击,导致邮件的分类结果异常,对垃圾邮件检测失效。本文对大语言模型训练阶段和预测阶段常见的安全威胁进行分析,并且深入探讨了目前针对大语言模型安全威胁的缓解策略。这些策略分别从两个方面入手进行了研究,包括在模型训练前过滤投毒样本和在模型训练中设计优化函数以提高模型鲁棒性。

图1 大语言模型不同阶段的安全威胁

大语言模型缺乏理解文本敏感性的能力,并且在训练过程中倾向于记忆训练数据集中存在的短语,敌手可以利用这一点对大语言模型进行逆向攻击从而提取其训练数据。这些训练数据常常包含人们的隐私信息,例如身份信息、位置信息、社交网络信息等。例如,在现代医疗领域,大语言模型可以用于疾病预诊断,患者提供个人就诊记录及健康状况等描述,模型根据这些信息给出可能的诊断以辅助门诊医生问诊。然而,大语言模型本身面临的隐私威胁会导致患者隐私信息的严重泄露。本文对大语言模型训练阶段和预测阶段常见的隐私威胁进行分析,并且深入探讨目前针对大语言模型隐私威胁的保护技术。

图2 大语言模型不同阶段的隐私威胁

未来研究方向

大语言模型目前存在的安全威胁与隐私问题制约了其大规模应用与进一步发展。大语言模型规模庞大,且其训练与决策算法具有不可解释性,这给探索并实践大语言模型的安全防御和隐私保护技术带来了困难。

目前,对大语言模型安全防御和隐私保护技术的研究仍然处于起步阶段,还有许多亟待解决的问题,总结为以下三点:

1)建立完善的评估机制。

2)寻找更高效的明文嵌入保护技术。

3)大语言模型的安全与隐私保护技术研究。

论文全文下载方式

1 识别下方二维码;2 点击文末“阅读原文”。

来源:《网络空间安全科学学报》2024年第1期

电话:010-89061756/ 89061778

如有侵权请联系:admin#unsafe.sh