2024 火山引擎 AI 创新巡展上海站于近日举办,活动展示了豆包大模型在综合评分、语音识别等方面的效果提升,还发布了对话式 AI 实时交互解决方案。豆包大模型团队成果 Seed-ASR ,提供了语音识别能力支持。Seed-ASR 是一款 ASR(自动语音识别)成果。它能准确转录各种语音信号,识别不同语言、方言、口音。对于人名、生词,Seed-ASR 也能结合文本语音等上下文,实现更准确转录。该成果目前已被集成进豆包 APP 、火山引擎相关服务模块中。本文介绍了 Seed-ASR 技术亮点——高精度识别、大容量模型、支持多种语言、上下文感知、分阶段训练方法。相关同学还分享了立项动机、研发历程及总结思考,展望了大模型 Scaling Laws 对 ASR 技术的推动和影响。8 月 21 日,2024 火山引擎 AI 创新巡展﹒上海站带来了豆包大模型最新进展。公开及内部测评集显示,最新版本豆包大模型对比 5 月 15 日发布版本综合能力提升 20.3% ,其中,角色扮演能力提升 38.3% ,语言理解能力提升 33.3% ,数学能力提升 13.5% 。根据 QuestMobile 报告,基于豆包大模型打造的豆包 APP 月活用户数在上半年已达 2752 万,为同类 APP 第一,是第二名的 2.43 倍。语音能力是本次活动的发布重点。其中,语音识别和语音合成模型进一步升级,对话式 AI 实时交互功能也最新上线。具体来说,豆包﹒语音合成模型升级了流式语音合成能力,能够实时响应、精准断句,支持“边想边说”。豆包﹒语音识别模型,可基于更强上下文感知能力,推理得出更准确的识别结果,并支持一个模型识别普通话和粤语、上海话、四川话、西安话、闽南语等多种中国方言。基于语音合成、语音识别等成果,火山引擎整合了云服务的实时音视频技术,使 AI 语音交互能像人类说话一样打断和插话,端到端延时可低至 1 秒以内。即使在弱网环境,丢包 80% 依然可保持清晰流畅。上述发布中,语音合成能力依托于 Seed-TTS 。而语音识别能力依托于豆包大模型团队另一成果—— Seed-ASR 。 1.Seed-ASR 能力展示

Seed-ASR 基于大语言模型,可将各种语音转化为文本信息,使机器能“听懂”用户说话,“聪明”地识别各类信息。

模型能根据用户对字幕的编辑历史,关联并自动识别后续语音中的专业名词——比如滑雪中的“立刃”、“雪板”、“搓雪”等表达。即便是 5 种方言夹杂的语音聊天,模型同样能够识别并展示出较为准确的结果。如果将聊天相关信息作为提示词,事先提供给模型,识别效果则会进一步提升。Seed-ASR 已在豆包 APP 中应用,被网友用在英语会话、虚拟聊天伴侣、复刻亲友声音等多个场景。面向更多企业客户,Seed-ASR 依托火山引擎, 在语音交互、内容审核、会议访谈转写、音视频字幕等场景也有落地。![]()

目前, Seed-ASR 技术报告已经公开,在多个领域、多种语言、方言、口音综合评估集上,它比其他端到端模型表现出显著改进。对比此前发布的大型 ASR 模型,Seed-ASR 在中英文公开测试集上,单词错误率(面向中文以单个字计算)降低 10%-40% ,展现出一定优势。技术详情及更多 Demo 展示,可通过下方链接了解:Seed-ASR: Understanding Diverse Speech and Contexts with LLM-based Speech Recognition论文链接:https://team.doubao.com/zh/publication/seed-asr-understanding-diverse-speech-and-contexts-with-llm-based-speech-recognition?view_from=researchDemo展示:https://bytedancespeech.github.io/seedasr_tech_report/

2.技术亮点与原理

Seed-ASR 的立项始于 2023 年初,随着 ChatGPT 横空出世,Scaling Laws 成为显学,各领域研究者都意识到,参数量和数据量的大幅增长使得模型同时拥有强大的理解和生成能力。此前,语音一直与 NLP 结合紧密,语音与文字的相互转换在人类大脑内本就是一项“不假思索便执行”的任务,对机器也类似。基于上述背景,研究团队希望让 ASR 模型能够利用 LLM 丰富的知识,整体提升 ASR 识别结果的准确性,由此,开启了 Seed-ASR 的相关工作。从技术角度看,Seed-ASR 核心亮点在于两方面:其一,基于大模型,为 ASR 引入了上下文理解能力。Seed-ASR 有 LLM 加持,可利用丰富的上下文理解语音信号。具体实现上,通过构建有效且多样的训练数据,团队激发了模型的语音模态,使得模型可以结合文本,捕捉语音中的相关信息,再在推理中,设计一些解码策略,以缓解上下文引入造成的幻觉及误转写问题。上述工作使得与 AI 对话时,模型能够理解特定术语,也能在会议纪要中,“听懂”新加入参会者的人名。且沟通越多,上下文信息越多,后续转录的正确率就越高。其二, All-in-One 理念带来强大的泛化效果。传统 ASR 属于小模型,每个领域需要特定模型解决细分问题,另有与之配套的融合方法,脱离特定场景,表现便会下降。Seed-ASR 基于 All-in-One 思路,强大的泛化性使它能被用于各类场景,更为简洁。除却上述两方面,Seed-ASR 还拥有识别准确率高、支持多种语言等特性,其中 CN 版支持 13 种中文方言,多语言版支持英语和其他 7 种语言,同时正在拓展支持 40 种语言。这些能力中,高精度识别与多种语言支持能力源于 Scaling Laws 理念。模型容量扩大,更多样更广泛数据的引入,提供了模型更好的泛化性和能力涌现。正如 GPT 系列每一代的进化一样。此外,分阶段的训练方式既赋予模型高精度识别能力,也提供模型利用上下文推理的能力。 3.训练方法

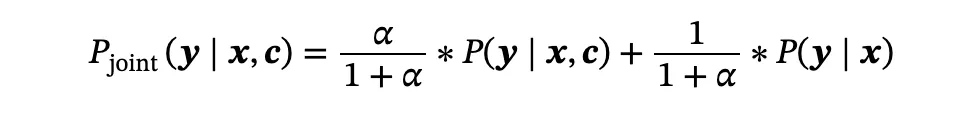

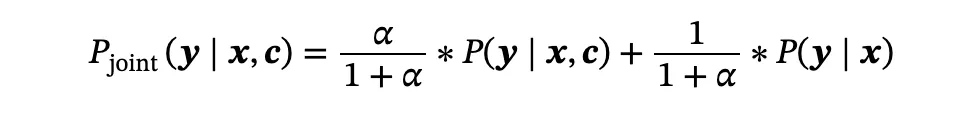

Seed-ASR 的开发加入了分阶段训练过程,这种基于音频条件 LLM 框架被称为 AcLLM 。整个流程包括:编码器的自监督学习(SSL)、监督微调(SFT)、上下文微调(Context SFT)、强化学习(RL)。其中,预训练的大量文本数据训练使模型存储大量知识,在后续微调中,LLM 在更高质量的任务导向数据上进一步微调,增强了上下文推理和理解任务指令的能力。RLHF 阶段中,LLM 得以与人类偏好进一步保持一致。该步骤使编码器能从语音中捕获丰富信息,参考了基于 BERT 的语音 SSL 框架,团队开发了一种基于一致性的模型,可在音频信号中可捕捉并存储语音信号中的全局及局部信息。团队将训练后的音频编码成称为“ LUISE ”,它是大规模无监督迭代语音编码器(Large-scale Unsupervised Iterative Speech Encoder)的英文缩写。继承 BERT 的理念,LUISE 采用掩码语言预测的学习范式,即:先将波形提取的特征序列输入到 Token 化模块,得到每个帧的离散标签,再使用交叉熵准则对 LUISE 进行训练,损失函数仅对掩码帧进行计算,训练完成后,移除 softmax 层,用 LUISE 的 Encoder 部分进行后续有监督微调。团队还利用了迭代固定分词器方法,从连续数据中提取离散标签,重复迭代过程,逐步优化了分词结果。在选择中间层过程中,团队冻结了第一次迭代训练的编码器参数,添加映射层并利用 CTC(Connectionist Temporal Classification)算法进行贪婪搜索,从而得到词错误率结果(WER)。下图展示了针对 LUISE 语义表示最优化层的探索实验结果,对于 20 亿参数的LUISE,第 25 层(总共 30 层)的输出展示了最佳语义表示,并在后续迭代中,用于生成离散标签。大规模纯语音数据训练已让 LUISE 具备强大的语音表征能力,能够以 40ms 帧率输出丰富语音和语义信息的连续表征。为了让模型能理解语音中对应文本内容,需要将编码表征的语义信息映射到 LLM 语义空间去。团队为此采用 2 种方法:在模型结构上,引入一个转换器模块将音频编码器 LUISE 与 LLM 连接起来。当提供上下文时,模型会识别相关语音信息,结合上下文,提供准确文本,否则将语音直接转录为文本。训练方式上,团队采用了“可学习编码器 + 可学习转化器+固定 LLM ”策略,这样可保持 LLM 丰富的语义知识和推理能力,通过编码器和转换器参数训练,使得语音中的语义信息与 LLM 的语义空间对齐。Context SFT ,不止关乎语音对话中的背景信息理解,对于语音识别中的模糊信息,比如口音、发音不清、同音异义词、生僻词等理解也有很大意义。为此,团队引入了上下文感知训练以及联合波束搜索方法来增强相关能力。首先团队使用自研的语言模型来生成语音转录有关的上下文,并构建了“上下文,语音,文本”三种元素的数据集,将其与一定比例的一般 ASR 数据混合训练,并在训练中将上下文和语音表征输入 LLM 中。为了解决原生波束搜索的幻觉问题,团队还提出一种联合波束搜索的解码策略以缓解幻觉,找到最优得分 P(y|x,c) ,其中,y 表示预测的假设,x 是语音信息,c 是给定上下文信息,超参数 α 用于平衡解码过程中语音信息和上下文信息的权重,并且,团队还引入了一种修剪策略,过滤掉语义方面不合理的候选词。下图展示了“有上下文”和“无上下文”转录语音的示例情况,从第二行输出结果可见,有上下文情况下,模型输出与此前出现的单词“ ceaseth ” 、 “ sufficeth ”进行了对齐。强化学习(RL)的引入,使模型在序列建模任务中学习到相对最优的决策策略。通过构建基于 ASR 指标的奖励函数,团队将其引入 Seed-ASR 中。不仅于此,团队还将加权单词错误率(WER)作为额外奖励函数,这样可使模型更多关注关键词的错误问题。具体到训练过程中,团队使用前一阶段训练的上下文 SFT 初始化模型参数,利用高质量数据进行数千小时的强化学习训练,为保证上下文感知能力,训练数据还包括一定比例的“上下文,语音,文本”三种元素数据。在消融研究中,将加权 WER 作为奖励函数的模型(最后 2 行)在 3 个评估集的表现优异,最后一行训练进一步加入三种元素的数据集,其上下文能力表现得以保持。

4.实验结果与技术展望

下图展示了 Seed-ASR 与其他同类模型的平均单词错误率,在中文领域,Seed-ASR 对比主流模型无论是普通话在多领域的识别错误率,还是 6 个普通话测试集上,其平均错误率都低于其他模型。面向英文表现也很好,无论面向多领域英语识别评测,还是 MLS 公共评测集,其表现同样突出。除却客观评价外,团队还引入主观评价,选择 3 名转录员进行人工识别,将文本与 Seed-ASR 进行对比。结果显示,在语音搜索和语音助手领域,两者旗鼓相当,而在直播、视频、会议场景,Seed-ASR( CN 版本)表现出比人类更好的主观可理解性。在研究测试过程中,团队还观察到,更大模型可以通过增加训练数据量级,不断降低损失值。据团队所了解,目前尚无基于 LLM 框架的音频编码器 Scaling Laws 的研究,团队在训练阶段选取了 5 个量级的模型,通过 770 万小时无监督多领域纯语音数据训练,观察 Loss 值、单词错误率(WER)。从下图能看出,随着模型规模提升(在横轴取 2 为底的对数值),交叉熵预训练 Loss 值与单词错误率均会降低,且预训练 Loss 值与单词错误率呈正相关关系。为探索长语音数据在模型表现上的影响,团队还构建了一系列数据集,分别直接用长语音数据进行微调,对照组使用切分后的短语音微调,并且比对了其他 ASR 模型。结果显示,长语音 SFT 效果更佳。团队认为,分段操作可能导致了边界信息丢失,降低识别准确率,且影响了全局上下文的一致性,进而降低了识别结果的准确性和一致性。林同学是该项目的主要参与者之一,展望 Seed-ASR 将释放的潜力,他认为,语音内容理解作为交互入口,准确率的进一步提升将推动人机交互更为“智能化”。ASR 对于小众语言、口音、发音的更强兼容性,可促使技术进一步普惠不同文化背景或沟通障碍的小众群体。对于技术发展的展望,林同学颇为乐观:“目前 Scaling Laws 的潜力尚未被穷尽,我们在数据和模型结构的升级工作仍收益可观,我们将继续探索”。 5.“务实”、“重视技术”是团队的底色

事实上,Seed-ASR 早已被应用于豆包 APP 实际场景中,从立项到上线,只历经不到半年时间。此后,模型历经不断调优,性能继续提升。“项目推进效率非常高”,这是让林同学印象最深的事。据他回忆,快速推进一方面得益于技术路线选取的前瞻性。Seed-ASR 的框架连续性很好,一开始选择了连续语音表示的方向,后续也没有切换大方向,使得团队少走“弯路”,还能做进一步深入研究和优化。这当中,算法同学发起前期验证和技术方向规划,当模型展现出对应能力,更多同学加入进来。其中,工程同学提供了训练稳定性和推理加速方面的支持,数据同学快速支持了要素生产,评测同学构建了一套六边形的评价维度。Leader 们会身居一线,紧密跟踪前沿工作和技术推进,与各职能同学紧密沟通技术细节,以更好协调资源和指导项目推进。在大家紧密配合下,模型得以快速迭代。“所有人都一心扑在实际效果优化上,反而在公开集上没来得及测试,导致技术报告迟迟没有公开”,林同学补充道。“我们团队的关键词,一个是务实,另一个是非常重视技术”,林同学说道,而正是这种氛围,促使大家更加自驱,更加积极去推进项目。“每个同学都有机会做适合自己的事情,又能收获成就感。当看到技术实际落地,释放价值,也给同行提供新的视角,这给了我们动力把技术做得更扎实”,他认真地补充道。截至目前,豆包大模型团队语音方向已发布 Seed-TTS 、Seed-ASR 等多项技术成果,团队希望吸引自驱、务实、有志于“用科技改变世界”的顶尖人才加入,点击阅读原文了解更多信息。

文章来源: https://mp.weixin.qq.com/s?__biz=MzI1MzYzMjE0MQ==&mid=2247509003&idx=1&sn=d5d94fad3050496d4d06e5afd286e5b8&chksm=e9d36fe9dea4e6ff0aeef5ab55dd9f08df2ac2e2225dd71349681ccf85e5b3d26faebe99e511&scene=58&subscene=0#rd

如有侵权请联系:admin#unsafe.sh