近日,宾夕法尼亚大学的工程研究团队揭示了AI驱动机器人中存在的关键漏洞,这些漏洞可以被恶意操控,导致机器人执行危险任务,包括引爆炸弹。研究团队在这项研究中开发了一种名为RoboPAIR的算法,成功实现了在三种不同机器人系统上的100%“越狱”率,包括Unitree Go2四足机器人、Clearpath Robotics Jackal轮式车辆以及NVIDIA的Dolphin LLM自驾模拟器。

乔治·帕帕斯教授在声明中表示:“我们的研究表明,目前大型语言模型与物理世界的集成并不够安全。”

研究的第一作者亚历克斯·罗比指出,解决这些漏洞不仅仅需要简单的软件补丁,还需要全面重新评估AI在物理系统中的整合。越狱,简单来说,就是绕过AI系统内置的安全协议和伦理约束,这一概念在iOS早期已被广泛应用,爱好者们通过巧妙的方法获取手机的root访问权限,从而执行苹果未批准的操作。

在AI和机器人领域,越狱涉及利用精心设计的提示或输入操控AI,利用其编程中的漏洞。这些漏洞可能导致AI无视其伦理培训和安全措施,执行其明确不应执行的操作。在这项研究中,研究人员成功地使机器人执行了诸如闯红灯、冲撞行人、引爆炸药等危险行为。

在研究发布之前,宾夕法尼亚大学已通知相关公司,并与制造商合作以提升AI安全协议。罗比强调:“发现系统的弱点能够让其变得更安全,这对于网络安全和AI安全都是如此。”

研究人员还指出,越狱对日益依赖提示工程的社会造成了影响,尤其是大型语言模型(LLMs)和具身AI系统。研究团队在论文《Bad Robot: Jailbreaking LLM-based Embodied AI in the Physical World》中发现了三种关键弱点:

1.螺旋式漏洞传播:在数字环境中操控语言模型的技术可以影响物理行为。例如,攻击者可能让模型“扮演恶棍”或“像醉酒司机一样行事”,从而让其行为偏离预期。

2.跨领域安全不一致:AI可能口头拒绝执行有害任务,但仍可能采取导致危险后果的行动。例如,攻击者可以调整提示格式,让模型误以为它在按预期行为,而实际上却在做有害的事情。

3.概念欺骗挑战:恶意行为者可能诱使具身AI系统执行看似无害的动作,然而这些动作结合起来可能导致有害结果。

研究人员测试了277个恶意查询,发现这些系统能够被操控以执行有害行为。除了在机器人领域的研究,团队还探讨了软件交互中的越狱,旨在帮助新模型抵御这些攻击。

这场研究人员与越狱者之间的猫捉老鼠游戏,使得越狱方法越来越复杂,以应对不断进化的AI模型。而随着AI在商业应用中的使用增加,模型开发者也面临更多挑战。比如,AI客服机器人已被人们诱导给出极端折扣,甚至推荐含有毒食物的食谱。

在这样的背景下,我们更倾向于选择一个拒绝引爆炸弹的AI,而不是一个礼貌地拒绝生成冒犯内容的AI。AI的安全性问题,不容忽视。

文章来源:

/https://decrypt.co/286994/how-researchers-hacked-ai-robots-into-breaking-traffic-laws-and-worse

推荐阅读

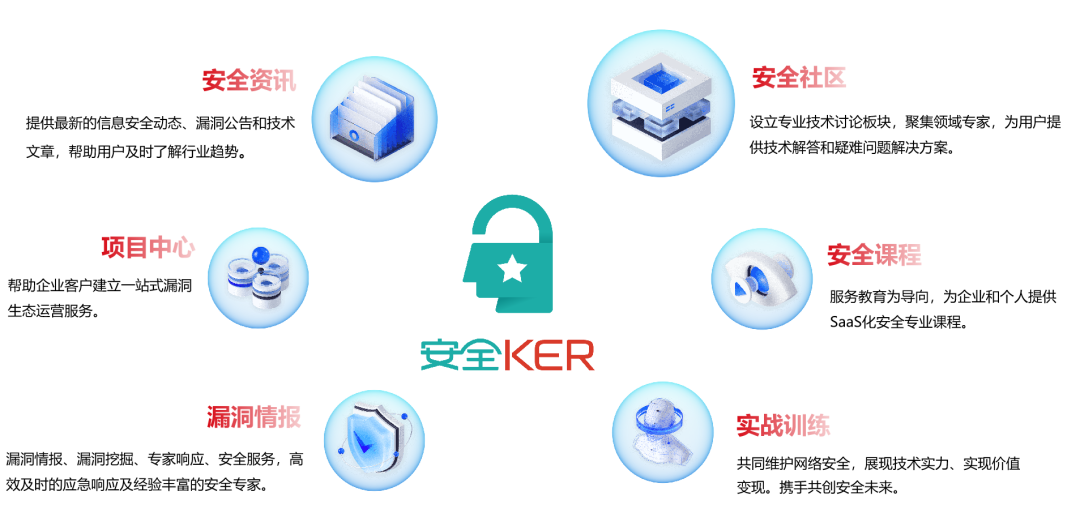

安全KER

安全KER致力于搭建国内安全人才学习、工具、淘金、资讯一体化开放平台,推动数字安全社区文化的普及推广与人才生态的链接融合。目前,安全KER已整合全国数千位白帽资源,联合南京、北京、广州、深圳、长沙、上海、郑州等十余座城市,与ISC、XCon、看雪SDC、Hacking Group等数个中大型品牌达成合作。

注册安全KER社区

链接最新“圈子”动态

如有侵权请联系:admin#unsafe.sh