2024-11-20 22:31:33 Author: www.cybersecurity360.it(查看原文) 阅读量:1 收藏

Negli ultimi 15 anni i metodi e le tecniche di manipolazione psicologica perseguite tramite la creazione di contenuti online, note come psyops, hanno conosciuto una nuova epoca d’oro, incorrendo in trasformazioni radicali.

Di norma nel passato, anche recente, erano governi e agenzie specializzate a gestire questo tipo di operazioni, ma l’avvento del web 2.0, molto più decentrato e interattivo, ha democratizzato la possibilità di creare contenuti psyops, ora alla portata di organizzazioni, singoli individui e gruppi di attivisti.

Abbiamo quindi assistito a un crollo delle barriere tecnologiche e finanziarie che un tempo rendevano queste pratiche appannaggio esclusivo di attori statali e agenzie iperspecializzate.

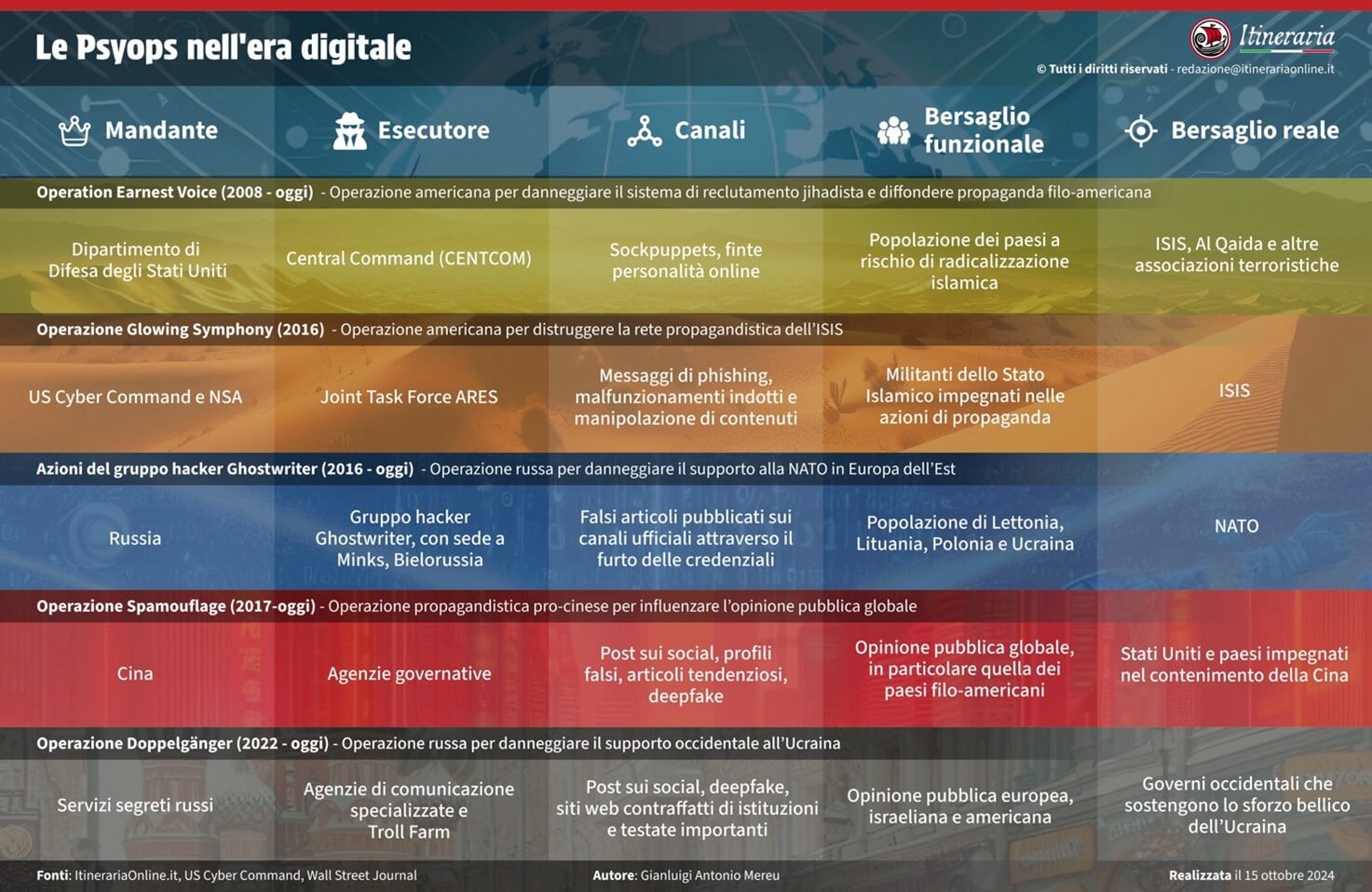

Fonte: Itineraria.

Psyops: il ruolo del web 2.0 nella manipolazione digitale

L’avvento del web 2.0 ha segnato un cambiamento profondo: mentre prima le persone utilizzavano il web esclusivamente in maniera consultiva, muovendosi in un ambiente statico, il nuovo assetto della rete ha permesso partecipazione, interattività, condivisione, dando a ogni singolo utente la possibilità di diventare creatore di contenuti.

Facebook, Instagram, X/Twitter, YouTube, sono arene che permettono a miliardi di persone di interagire ed influenzarsi vicendevolmente in tempi brevissimi. Questi ecosistemi creano quindi grandissime opportunità per mettere in opera operazioni di condizionamento psicologico su larga scala.

Nati con l’obiettivo di connettere persone e facilitare la libera circolazione di idee, questi ecosistemi, oltre ad essere un immenso bacino di profilazione e raccolta dati, permettono a Stati, gruppi di interesse e individui di orchestrare massicce campagne di disinformazione e condizionamento psicologico, con costi risibili. È possibile creare falsi profili, utilizzare reti di bot o troll farm, alimentando dibattiti polarizzati su grande scala. Ne risulta una maggiore vulnerabilità delle opinioni pubbliche.

I social network sono soliti utilizzare intelligenze artificiali (I.A.) per migliorare l’esperienza dell’utente. L’ecosistema di Meta utilizza i dati generati dalle interazioni dei fruitori dei propri servizi per addestrare la propria I.A., in modo da renderla sempre più capace di fornire risultati progressivamente più aderenti alle richieste degli utenti stessi.

L’enorme mole di dati generata può essere utilizzata per “mappare” le personalità e i bisogni degli utenti e fornire non solo contenuti su misura ma anche campagne di marketing personalizzate.

Tuttavia, la sempre più precisa profilazione dei comportamenti online dei fruitori offre il fianco, purtroppo, anche a un utilizzo malevolo delle piattaforme social. È infatti possibile manipolare il flusso di contenuti tramite pratiche che sfruttano gli stessi meccanismi di raccolta e presentazione dei dati.

Le troll farm e l’uso malevolo delle piattaforme social

È il caso delle famigerate troll farm. Una troll farm è un’organizzazione o un gruppo di persone che opera coordinando grandi quantità di profili falsi o account online con l’obiettivo di diffondere disinformazione, manipolare l’opinione pubblica o spingere una narrazione su piattaforme di social media, forum e altri spazi online.

La troll farm può essere controllata da uno stato, da un ente privato oppure essere il risultato di un movimento spontaneo.

Le troll farm spontanee sono suscettibili all’influenza di soggetti organizzati e spesso diventano megafono di campagne altrui. Con un investimento economico contenuto è possibile creare vastissime operazioni di disinformazione.

L’interconnessione creata dai social ha contribuito ad abbattere le frontiere cibernetiche tra i Paesi, consentendo ad attori stranieri di manipolare le opinioni pubbliche con pochi rischi per gli agenti sul campo.

Ne è un chiaro esempio l’agenzia russa Internet Research Agency che opera molto sui social network seguendo principalmente due modalità d’azione che si amplificano a vicenda. Il primo passo è la creazione di profili falsi, dotati di un certo livello di coerenza al fine di apparire autentici, utilizzati successivamente per creare contenuti ingannevoli dotati di forte impatto emotivo.

I contenuti che suscitano emozioni forti come rabbia e paura hanno maggiori probabilità di generare interazioni con gli utenti, venendo quindi mostrati in modo più frequente nei feed.

A questo punto vengono utilizzate vere e proprie reti di bot per amplificare il più possibile la risonanza dei contenuti ingannevoli. I bot sono software automatizzati che vengono utilizzati per gestire con uno sforzo minimo l’attività di migliaia di profili social falsi.

I profili gestiti dai bot sono più semplici da identificare rispetto a quelli creati da esseri umani, ma compensano la bassa qualità con la facilità con la quale possono essere gestiti. I profili bot sono programmati per aumentare la circolazione dei post ingannevoli tramite ricondivisioni e “mi piace” messi in automatico, in modo da saturare ulteriormente le bacheche degli utenti.

Questa tipologia di campagna permette di raggiungere un vasto numero di persone ad un costo molto basso, inoltre, trasforma i social in un terreno di coltura perfetto per la disinformazione.

La disinformazione nel contesto della guerra ibrida

In un contesto di guerra ibrida la battaglia della disinformazione non si ferma al solo utilizzo dei social network: tutte le potenzialità del web sono a disposizione. Nel giugno del 2023 il governo francese denunciava una massiccia operazione di disinformazione portata avanti da “entità statali o entità associate allo Stato russo”.

L’operazione soprannominata Doppelgänger da DisinfoLab – un’associazione indipendente non a scopo di lucro specializzata nella lotta alla disinformazione – oltre ai soliti profili e pagine false sui social prevedeva anche l’utilizzo di pagine “clone” di siti istituzionali e importanti testate giornalistiche. Tra i siti vittime di clonazione ritroviamo Le Monde, Le Parisien e Le Figarò oltre a quello del ministero degli esteri transalpino.

I siti contraffatti attiravano gli utenti ignari tramite la tecnica del typesquatting, sfruttando quindi i comuni errori di battitura che si commettono in fase di ricerca sul web che però conducevano su pagine che esteticamente erano identiche alle originali ma con contenuti ingannevoli e fuorvianti.

Doppelgängernon si è fermata a questo: infatti, oltre a Facts Matter, una falsa Ong che si spacciava tutrice della privacy, veniva identificato anche un sito chiamato Reliable Recent News che si occupava di integrare con un falso network di notizie i contenuti ingannevoli che circolavano sui siti clone.

Dietro a questa vastissima operazione Meta ha identificato come colpevoli Struktura e Social Design Agency, società di comunicazione con legami con il governo del Cremlino.

AI sempre più usata per sorveglianza e raccolta informazioni

Le potenzialità delle intelligenze artificiali non si fermano all’ambito della manipolazione informativa. Le nuove tecnologie informatiche giocano un ruolo di prim’ordine in conflitti che travalicano l’utilizzo di armamenti convenzionali e puntano alla destabilizzazione del fronte interno nemico.

Oltre alla propaganda e alla disinformazione online l’IA viene massicciamente utilizzata nella sorveglianza e nella raccolta di informazioni.

Ne è un esempio il Natural Language Processing (NLP), un sistema di intelligenza artificiale che ha la capacità di comprendere il significato dei testi.

L’NLP offre quindi la possibilità di monitorare enormi quantità di testi circolanti online, potenziando anche le possibilità di raccolta informazioni e censura. Le nuove potenzialità delle IA vengono utilizzate anche in modo aggressivo, per potenziare e rendere maggiormente efficaci e difficilmente contrastabili gli attacchi DDoS (Distributed Denial of Service).

L’impatto dei deepfake

Tuttavia, è nel deepfake che l’intelligenza artificiale impatta in modo massimamente scioccante. L’architettura più utilizzata nella creazione di materiale audio e video falsi è la Generative adversial networks (GANs).

Questo tipo di architettura offre molteplici possibilità: creazione di immagini e video di alta qualità partendo da immagini e video a bassa qualità; creazione di contenuti per film, animazioni e videogiochi; creazione di immagini a partire da descrizioni testuali, e tanto altro.

Purtroppo, alle luci si sovrappongono le ombre e gli utilizzi malevoli di questo tipo di tecnologie disegnano scenari inquietanti.

È noto il video fatto circolare sui social nel quale Volodymyr Zelensky chiedeva alle truppe ucraine di deporre le armi e arrendersi alla Russia.

Esistono molti altri esempi di materiale multimediale creato con scopi malevoli. Il cosiddetto deepfake diventa così un’arma estremamente potente, con in dote un’enorme potenzialità di suscitare forte impatto emotivo volto alla disinformazione. Video e audio riescono a incidere con maggiore efficacia rispetto alla scrittura sulle coscienze di ignari utenti, obiettivo di campagne volte a destabilizzare l’opinione pubblica.

Società democratiche vulnerabili alle psyops

Le società democratiche sono per loro natura aperte: fondate su principi di libertà di espressione, trasparenza, partecipazione civica. Questa loro natura le porta fatalmente ad essere vulnerabili alle operazioni di psyops nell’era digitale.

Le democrazie sono quindi intrinsecamente permeabili: l’accesso illimitato ai social media, l’incredibile velocità con cui informazioni vere o false possono essere immesse in circolazione senza il controllo dei gatekeeper analogici tradizionali, come redazione e giornalisti, concorrono a creare un ambiente fertile per la diffusione di disinformazione.

Il pluralismo informativo e di opinione è un pilastro delle democrazie. Ma la frammentazione e la proliferazione contenutistica del web 2.0 creano bolle informative, “serre” customizzate dove il singolo fruitore è esposto solo a contenuti che confermano i suoi preesistenti convincimenti.

Questo fenomeno, noto come “effetto camera dell’eco”, massimizza la polarizzazione e rende il fruitore indisponibile a qualunque confronto costruttivo con chi abbia opinione diverse.

Gli stessi algoritmi dei social media giocano un ruolo in questo processo, promuovendo la visualizzazione di contenuti tesi a massimizzare l’ingaggio dell’utente, provocando forti reazioni emotive tese a incentivarne la radicalizzazione.

La stessa natura aperta dei sistemi democratici porta ad un controllo sulla informazione più lasco rispetto ai regimi autoritari.

Questa apertura rende le democrazie più vulnerabili a gruppi e attori stranieri malintenzionati, in grado di seminare discordia nella mediosfera, minando opportunisticamente la fiducia stessa degli utenti nelle istituzioni democratiche: disinformazione, propaganda, provocazioni, sono tutti strumenti utili a destabilizzare e confondere il dibattito politico e di conseguenza le pubbliche opinioni.

In un mondo, in una società e in una sfera informativa sempre più complessi, multiformi e sfaccettati, dove anche solo rispetto a 20 anni fa informarsi è diventato un lavoro che richiede tempo e dedizione, il rischio è che gli elettori non siano più in grado di distinguere tra verità e menzogna, compromettendo così sul nascere i processi decisionali alla base delle istituzioni democratiche.

Fonte: Itineraria.

Sistemi autoritari più resistenti alla disinformazione esterna

I sistemi autoritari, al contrario, hanno una capacità di resistenza alla disinformazione esterna enormemente superiore.

Gli stessi strumenti di controllo dell’informazione interna costituiscono un formidabile argine anche contro l’azione di agenti destabilizzanti esterni. Ne è un esempio lampante il Great Firewall of China che, allo stesso modo in cui un comune firewall filtra il traffico di rete per bloccare eventuali minacce, monitora la navigazione web, bloccando di fatto agli utenti l’accesso alle principali piattaforme social e motori di ricerca che non possono essere asserviti al controllo e alla propaganda del Partito comunista cinese.

Di conseguenza si sono costruite in Cina delle piattaforme, sia social che informative, totalmente sotto il controllo e la censura del partito come ad esempio: Baidu, il principale motore di ricerca che fa anche da enciclopedia online; WeChat, popolare piattaforma di messaggistica istantanea; Weibo, principale social network di Pechino e Youku che rappresenta l’alternativa a YouTube.

La Cina, tuttavia, non è l’unico esempio di regime dotato di simili strumenti di controllo, anche la Russia infatti possiede social network propri come VKontakte e Odnoklassniki e contestualmente è in grado di interdire l’accesso ai propri utenti alle piattaforme esterne.

È superfluo citare altri esempi simili, il fatto che emerge lampante è che i regimi autoritari possiedono un indubbio vantaggio sulle controparti democratiche: possono infatti agire con campagne di disinformazione destabilizzanti senza, di fatto, essere attaccabili sullo stesso terreno.

如有侵权请联系:admin#unsafe.sh